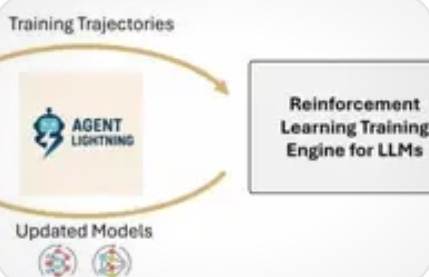

在人工智能领域,AI Agent(智能体)正从单一任务执行向复杂场景渗透,但训练优化环节始终存在技术瓶颈。微软最新发布的Agent Lightning框架,通过创新性解耦设计与算法突破,为AI Agent的训练提供了全新解决方案。本文从技术架构、算法创新、系统兼容性三个维度,深度解析其核心性能亮点。

一、解耦式架构:训练与执行彻底分离

1. “Training-Agent”解耦设计

Agent Lightning首次实现AI Agent执行与强化学习训练的完全解耦。其架构由Lightning Server和Lightning Client组成:

Server端:作为训练“大脑”,管理强化学习算法、分配GPU资源、更新模型参数,通过类OpenAI API向客户端暴露模型服务。

Client端:集成OpenTelemetry等可观测性工具,透明收集Agent执行轨迹(状态、动作、奖励),无需修改任何Agent代码即可实现数据捕获。

2. 零代码修改兼容性

该框架支持无缝接入任何Agent框架(如LangChain、AutoGen、OpenAI Agents SDK),甚至支持无框架的纯Python OpenAI应用。开发者无需重构现有代码,即可为Agent添加强化学习训练能力。

二、分层强化学习算法:LightningRL

1. 信用分配机制

针对多轮交互场景,LightningRL引入分层信用分配:

高层分配:将任务最终奖励分解至每次LLM调用步骤(如每次工具使用的奖励均等于最终奖励)。

低层优化:将分解后的单次调用奖励转化为独立强化学习问题,可直接复用PPO、GRPO等成熟算法,避免序列过长导致的计算开销。

2. 数据利用率提升

通过统一数据接口,Agent执行轨迹被抽象为MDP(马尔可夫决策过程)的标准格式,使复杂交互逻辑(如多Agent协作)可被高效训练。实验显示,在Text-to-SQL任务中,该框架使多Agent系统性能提升显著。

三、系统级优化:可扩展性与效率

1. 分布式训练支持

Client端支持多节点并行运行,数据吞吐量大幅提升。结合自动中间奖励(AIR)机制,可基于系统监控信号为中间步骤分配奖励,缓解稀疏奖励问题。

2. 错误处理与容错性

内置全面错误处理机制,单个Agent崩溃不影响整体训练流程,确保长时间训练的稳定性。

四、实验验证:跨场景性能提升

在Text-to-SQL、开放域问答、数学问答等任务中,Agent Lightning均展现持续性能提升:

多Agent系统优化:在LangChain构建的SQL生成任务中,选择性优化SQL编写与重写Agent,实现协同性能提升。

复杂工具调用:AutoGen数学Agent通过框架训练,精准调用计算器工具,解决数学问题。

大规模检索场景:基于OpenAI Agents SDK的RAG智能体,在维基百科检索任务中,优化检索策略与文本推理能力。

微软Agent Lightning框架通过解耦式架构、分层强化学习算法及系统级优化,重新定义了AI Agent的训练范式。其零代码修改兼容性、多场景适配能力及实验验证的性能提升,为开发者提供了高效、灵活的Agent优化工具。随着AI Agent向更复杂场景渗透,Agent Lightning有望成为推动AI应用落地的关键基础设施。

版权声明

本文仅代表作者观点,不代表百度立场。

本文系作者授权百度百家发表,未经许可,不得转载。